안녕하세요. 이번에 리뷰할 논문은 중앙대팀에서 IEEE Access 2021에 publish한 Multiple-Clothing Detection and Fashion Landmark Estimation Using a Single-Stage Detector입니다.

IDENX

INTRODUCTION

PROPOSED METHOD

EXPERIMENTS

RESULTS

CONCLUSION

INTRODUCTION

Fashion dataset에 대한 기존 model들을 High computational requirements이 필요했습니다. 그러나 본 논문에서 제안 제안한 모델은 아래와 같은 contribution을 가지고 있습니다.

Contribution

(1) low-power devices에 적합하도록 accuracy와 speed를 모두 좋은 가벼운 모델을 만들었습니다.

(2) One-stage detector를 통해 multiple cloths와 landmarks를 빠르게 탐지했습니다.

(3) EfficientDet을 modification하여 해당 모델을 만들었습니다.

- Trains core input features with different resolutions

- Compound scaling to the backbone feature network

주요 실험 결과

- Bounding box detection: 0.686 mAP

- Landmark estimation: 0.450 mAP

- Inference time: 42 ms

PROPOSED METHOD

MODEL

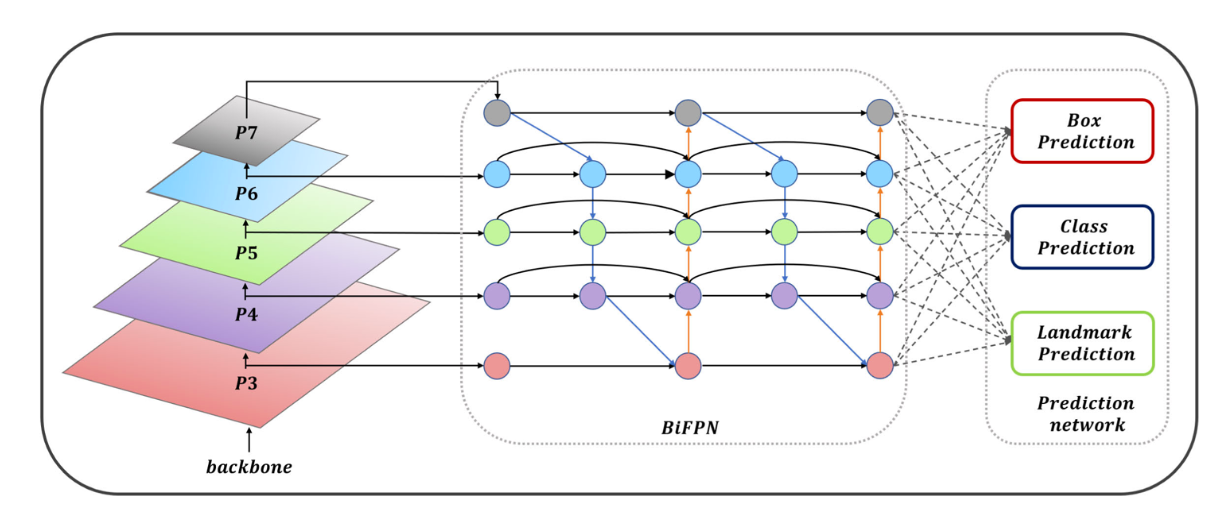

FIGURE 3. Overall network structure (EfficientDet-D1, 4 BiFPN layers)

위 Overall network structure보시면, Head부분은 Box, Class, Landmark 나눠져서 task 수행합니다.

EfficientDet

본 논문에서 제안한 모델은 EfficientDet 유사한 것을 알 수 있습니다.

EfficientDet에서 제안한 BiFPN은 위 그림과 같은 구조이며, FPN에서 레이어마다 가중치를 주어 좀더 각각의 층에 대한 해상도 정보가 잘 녹아낼수 있도록 하는 장치입니다. PANet에서 처럼 보톰업과 탑다운을 동시에 지니고 있으면서도 여기저기 제일 중요한 인사이트를 줄수있는 곳에다가 길을 뚫어놓은 것입니다.

그리고 EfficientDet의 fast normalized fusion로 그대로 쓰는데, weight를 fusion하는 방식 중 speed와 accuracy를 모두 가져갈 수 있는 방식입니다.

PREDICTION HEAD

FIGURE 4. Structure of the prediction network

Prediction head는 위 구조에서 가장 왼쪽에 있는 이 부분으로 prediction을 수행합니다. 먼저 3 × 3 convolution three times for each task에 수행하고 filter size 3, stride 1, and padding 1로 the output channel을 조정합니다.

LOSS FUNCTION

본 논문에서는 total loss를 구하기 위해 focal loss와 C-IoU(Complete IoU)를 사용합니다.

FOCAL LOSS

single-stage object detector의 단점 중 하나 인 imbalance problem을 개선하기 위해 RetinaNet의 focal loss 를 사용합니다.

C-IoU

Complete IoU Loss는 bounding box regression을 위해 사용됩니다.

Total Loss

v: visibility of clothing landmarks

landmark offset: the same equation as the landmark loss was applied.

아래 그림은 generalized IoU loss and distance/complete IoU method 비교한 그림입니다.

FIGURE 5. Example of the generalized IoU loss and distance/complete IoU method.

distance/complete IoU 은 center coordinates의 거리를 고려하는 것이 특징적입니다.

TRAINING

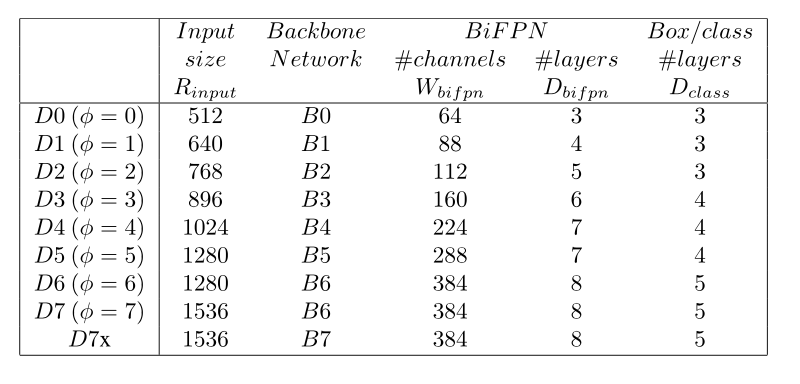

TABLE 1. Scaling configs for EfficientDet.

EfficientDet 중 D0와 D1 model을 사용해 높은 near-real-time inference speed를 낼 수 있도록 합니다. Input resolutions은 512 × 512, 640 × 640이며, backbone network로는 EfficientNet-B0, B1를 사용합니다. batch size는 16이고, AdamP optimizer를 사용합니다.

EXPERIMENTS

BACKBONE

Landmark는 2가지가 있는데 single clothing landmark estimation과 multi-human keypoints estimation가 있습니다. 해당 실험에서는 EfficientNet-B1을 Backbone으로 실험을 수행했습니다.

TABLE 2. Model performance based on EfficientDet-D0 and EfficientDet-D1.

COORDINATES CONVOLUTION LAYER

일반적인 CNN방식이 아닌 coordinate convolution방식 사용합니다. coordinate information를 input image와 input channel에 넣음으로써 성능을 높일 수 있다고 합니다.

FIGURE 6. Coordinates convolution layer.

RESULTS

DeepFashion2 DATASET

FIGURE 7. Definition of the DeepFashion2 dataset.

DeepFashion2 dataset은 13가지 클래스와 약 300가지의 landmark 존재합니다. 또한, 191,961 training sample과 32,153 testing samples를 포함하고 있습니다.

COMPARISON WITH PREVIOUS METHODS

TABLE 5. Results of performance comparison with the existing methods.

80epochs 뒤에 Best results를 달성했으며, EfficientDet MS COCO pre-trained model를 사용했다고 합니다.

실험 결과

parameters 개수는 7.3M이고, inference time은 42ms DeepFashion2 논문에서 사용한 Match R-CNN의 44.4M에 비해 굉장히 효율적임을 알 수 있습니다.

EXAMPLE OF THE PROPOSED METHOD

다양한 사이즈와 카테고리의 이미지에 적용한 demonstration입니다.

FIGURE 8. Result of the proposed model. Demonstrations were conducted on images of different sizes and categories.

CONCLUSION

결론적으로 본 논문은 EfficientDet을 적용해 multiple-clothing detection과 fashion landmark estimation을 했습니다. 그리고 inference time과 accuracy의 balance를 달성했습니다.

댓글